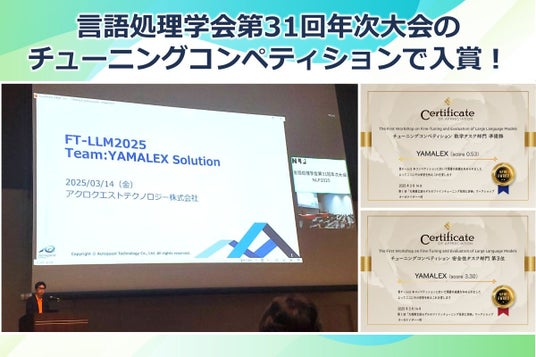

アクロクエストテクノロジー株式会社(本社:神奈川県横浜市・代表取締役:新免流、以下、アクロクエスト)のデータサイエンスチームであるAcroYAMALEX(以下、YAMALEX)は、言語処理学会第31回年次大会(NLP2025)で開催された『第1回「大規模言語モデルのファインチューニング技術と評価」ワークショップ』の「チューニングコンペティション」で入賞したことをお知らせします。

■第1回「大規模言語モデルのファインチューニング技術と評価」ワークショップとは

大規模言語モデル(LLM)のファインチューニング技術に関心のある研究者が議論を行うワークショップです。2025年3月に開催された第1回のワークショップでは、ファインチューニング技術を競うコンペティションを実施し、用いられた技術や結果について発表を行い、ファインチューニング技術に対する理解を深めるものとして開催されました。

コンペティションでは、以下2つの部門について、評価を行いました。

- 安全性チューニングタスク:安全性と有用性を両立した応答をするためのチューニングを行います。安全性への配慮を要するQAデータセット「AnswerCarefully」、一般ドメインのQAデータセット「ichikara-instruction」と同等のテストデータを用いて、安全性と有用性の2つの側面を評価します。

- 数学チューニングタスク:算数や数学の問題を解く能力を向上させるためのチューニングを行います。算数・数学の試験問題をテストデータとして評価を行い、モデルの数学能力を評価します。

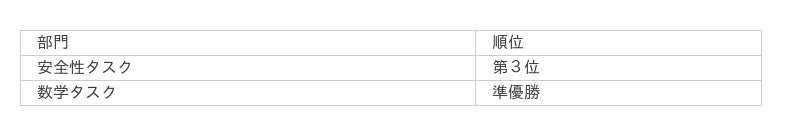

■YAMALEXチームの結果

当社の最先端技術研究チームである「YAMALEX」は、この大会にチームとして参加し、全18チームが参加する中で、両部門で入賞しました。

今回、LLMを利用してデータセットを構築し、LLMに対してコード生成、思考能力を向上させるためのファインチューニングを行い、精度の向上を実現しました。

▼言語処理学会第31回年次大会(NLP2025)

第1回「大規模言語モデルのファインチューニング技術と評価」ワークショップ

チューニングコンペティション

https://llm-jp.github.io/tuning-competition/index.html

■参加チーム概要

- チーム名: YAMALEX(ヤマレックス)

- メンバー:佐々木 峻、山本 大輝、樋口 慎

以下、YAMALEXチームリーダーでKaggle Grandmasterの山本と、機械学習エンジニアの佐々木のコメントです。

<山本コメント>

コンペティションに参加することにより、LLMへのコードや数学の解き方をはじめとした思考能力の与え方を学ぶことができました。特に数学は今回のベースモデルでは学習されていないもので、標準モデルだと精度が低く、推論時に何を推論させるのかといった仕組みまで踏まえて考える必要があり、難しいものでした。

LLM単独ではなく、コード生成をはじめとしたLLMへの思考過程の与え方を工夫することで精度を向上させられ、2位を獲得できました。

<佐々木コメント>

コンペティションでは13Bモデルをフルサイズでファインチューニングするという通常リソースの制約で実行することが難しいことにチャレンジできました。特に数学タスクに注力して取り組みましたが、ベースモデルの数学能力が低い中で、どの程度学習させれば数学能力が向上するのか、いざファインチューニングになるとどの程度時間がかかるのかなど学びが多いコンペティションでした。

アクロクエストは、これからもAI/機械学習やデータ分析・解析の技術向上を図り、お客様の課題解決とより良いサービスの創出に努力してまいります。

【参考情報等】

■言語処理学会第31回年次大会(NLP2025)

https://www.anlp.jp/proceedings/annual_meeting/2025/

■[発表資料]FT-LLM2025 Team:YAMALEX Solution

https://llm-jp.github.io/tuning-competition/pdfs/yamalex_ppt.pdf

アクロクエストテクノロジー株式会社

アクロクエストテクノロジー株式会社

アクロクエストテクノロジー株式会社 広報 担当/白井 智子(しろい さとこ)

本件に関するお問い合わせは、以下のメール、またはお問い合わせフォームにてお願いいたします。

〒222-0033 神奈川県横浜市港北区新横浜3-17-2 友泉新横浜ビル 5階

E-MAIL(営業) : acropr@acroquest.co.jp

お問い合わせフォーム

https://www.acroquest.co.jp/company/contact-all